Dans leur quête de nouvelles particules et forces fondamentales de la nature, l’un des plus grands défis pour les expériences de haute énergie du Grand collisionneur de hadrons (LHC) est de veiller à la qualité des importants volumes de données collectées. Pour y parvenir, des systèmes de contrôle de la qualité des données sont en place pour les différents sous-détecteurs d’une expérience, et jouent un rôle clé dans la vérification de la précision des données.

L’un de ces sous-détecteurs est le calorimètre électromagnétique de CMS, composant fondamental du détecteur. Le calorimètre électromagnétique mesure l’énergie des particules, principalement des électrons et des photons, produites lors des collisions au LHC, ce qui permet aux scientifiques de reconstituer les désintégrations des particules. Veiller à la précision et à la fiabilité des données enregistrées dans le calorimètre électromagnétique est crucial pour l’expérience.

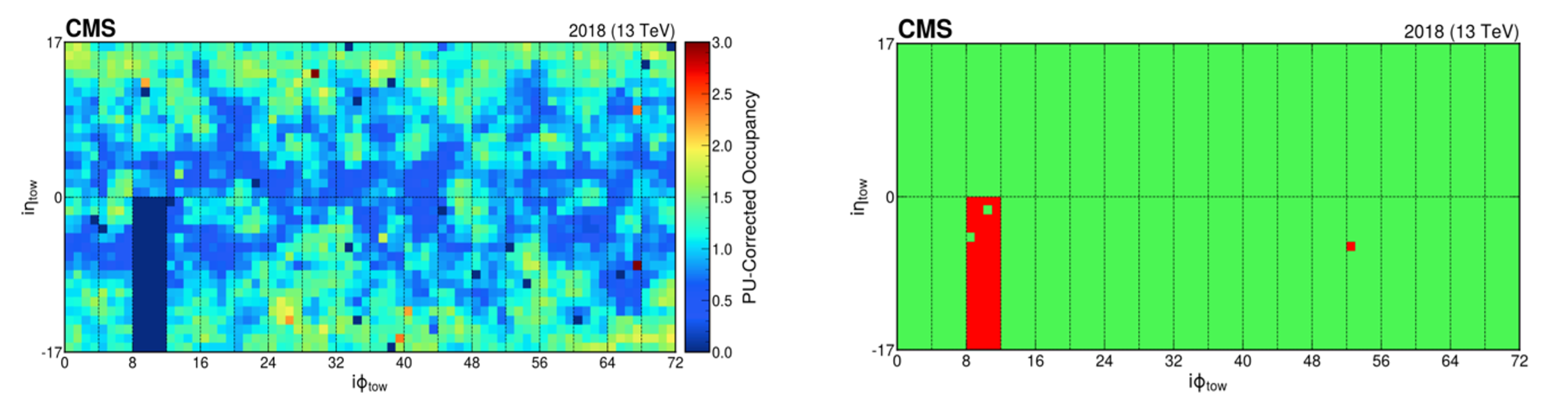

Pendant la troisième période d’exploitation du LHC, actuellement en cours, les scientifiques de CMS ont développé et mis en place une technique innovante d’apprentissage automatique afin d’améliorer le système actuel de contrôle de la qualité des données du calorimètre électromagnétique. Détaillée dans une publication récente, cette nouvelle approche promet de rendre la détection d’anomalies dans les données plus précise et plus efficace. Une telle fonctionnalité en temps réel est essentielle dans l’environnement dynamique du LHC afin de repérer et corriger rapidement les problèmes liés au détecteur, et ainsi d’améliorer la qualité générale des données. Le nouveau système a été mis en place en 2022 dans la partie tonneau du calorimètre électromagnétique, et en 2023 dans les bouchons.

Le système traditionnel de contrôle de la qualité des données de CMS utilise un logiciel conventionnel qui repose sur un ensemble de règles prédéfinies, de seuils et d’inspections manuelles, qui permettent d’alerter l’équipe de la salle de contrôle en cas d’éventuelles anomalies dans le détecteur. Cette approche nécessite de fixer des critères spécifiques pour définir les données jugées normales et celles qui ne le sont pas. Bien qu’efficaces, ces méthodes peuvent potentiellement passer à côté d’anomalies subtiles ou inattendues qui ne sont pas prises en compte dans les modèles prédéfinis.

Le nouveau système d’apprentissage automatique est capable lui de détecter ces anomalies et vient donc compléter le système traditionnel de contrôle de la qualité des données. Il est entraîné à reconnaître le comportement normal du détecteur à partir de données de qualité existantes, et à repérer un éventuel écart. L’auto-encodeur du système de détection des anomalies constitue le cœur de cette approche. Les auto-encodeurs, un type de réseau neuronal spécialisé, sont conçus pour l’apprentissage non supervisé.

Le système, alimenté avec des données du calorimètre électromagnétique sous forme d’images en 2D, permet également de repérer des anomalies qui évoluent au cours du temps, grâce à de nouvelles stratégies de correction – un aspect essentiel pour repérer des tendances qui ne sont pas forcément visibles immédiatement, mais qui apparaissent au fil du temps.

Le nouveau système avec auto-encodeur améliore non seulement la performance du détecteur CMS, mais sert également de modèle pour la détection d’anomalies en temps réel dans différents domaines, soulignant ainsi le potentiel d’adaptation de l’intelligence artificielle. Par exemple, les secteurs qui gèrent des flux de données à grande échelle et à haut débit, tels que la finance, la cybersécurité et la santé, pourraient bénéficier de systèmes d’apprentissage automatique similaires pour la détection des anomalies afin d’améliorer leur efficacité et leur fiabilité opérationnelles.

CMS n’est pas la seule expérience à améliorer sa performance grâce à l’intelligence artificielle, l’automatisation et l’apprentissage automatique. Pour en savoir plus, rendez-vous ici.

Pour en savoir plus :